reference: https://bskyvision.com/465

물체 검출 알고리즘 성능 평가방법 AP(Average Precision)의 이해

물체 검출(object detection) 알고리즘의 성능은 precision-recall 곡선과 average precision(AP)로 평가하는 것이 대세다. 이에 대해서 이해하려고 한참을 구글링했지만 초보자가 이해하기에 적당한 문서는 찾기..

bskyvision.com

Precision과 Recall

* Precision(정밀도) : 모든 검출 결과 중 옳게 검출한 비율

* Recall(재현율) : 마땅히 검출해내야 하는 물체들 중에서 제대로 검출된 것의 비율

Precison만으로 물체 검출 알고리즘의 성능을 평가하는 것은 적절하지 않다. 또한 Recall만으로 성능을 평가하는 것도 적절하지 않다. Precision과 Recall은 항상 0과 1사이의 값으로 나오게 되는데, Precision이 높으면 Recall은 낮은 경향이 있고, Precision이 낮으면 Recall이 높은 경향이 있다는 것이다. 따라서 어느 한 값 만으로 알고리즘의 성능을 평가하는 것은 거의 불가능하고, 두 값을 종합해서 알고리즘의 성능을 평가해야 한다. 그래서 필요한 것이 precision-recall 곡선 및 AP(Average Precision)이다.

precision-recall 곡선과 AP를 다루기 전에 먼저 살펴봐야 할 것이 있다. 물체를 검출했을 때 옳게 검출되었다와 옳게 검출되지 않았다를 구분해주는 기준, 즉 TP(옳은 검출)와 FP(틀린 검출)를 결정해주는 기준은 무엇일까? 그 기준은 바로 intersection over union(IoU)이다.

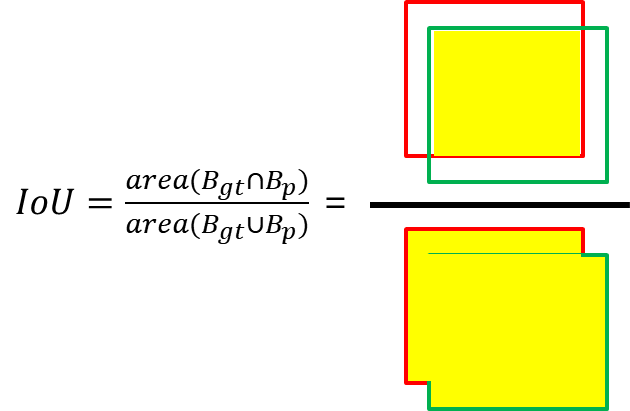

Interaction over Union(IoU)

* Interaction over Union(IoU) : 예측된 바운더리 박스와 ground truth 바운더리 박스간 중첩되는 부분의 면적을 측정해서 중첩된 면적을 합집합의 면적으로 나눠준 것

Precision-Recall 곡선

이제 Precision-recall 곡선(PR 곡선)을 다룰 준비가 되었다. PR 곡선은 confidence 레벨에 대한 threshold 값의 변화에 의한 물체 검출기의 성능을 평가하는 방법이다. confidence 레벨은 검출한 것에 대해 알고리즘이 얼마나 확신이 있는지를 알려주는 값이다. 만약에 어떤 물체를 검출했는데 confidence 레벨이 0.999라면 굉장히 큰 확신을 가지고 검출한 것이다.

댓글